Please select your location and preferred language where available.

支援 AI 的儲存解決方案

2025 年 3 月 17 日

生成式 AI 的使用迅速成長,擴及越來越多的應用,透過運用自然語言處理和影像生成技術的系統,為許多產業帶來創新突破。為保持競爭力,企業需要快速且高效率的資料處理能力,才能為 AI 模型充分利用大量資料。資料儲存和記憶體技術對於高效能的生成式 AI 系統至關重要。鎧俠長期致力帶動產業的快閃記憶體、SSD 和相關技術研發,推動 AI 的發展。

什麼是 AI?

AI 技術可讓電腦系統運用大量資料,執行傳統上需要依靠人類智慧的任務。兩種主要的 AI 類型分別為:傳統 AI (回應一組輸入) 和生成式 AI (產生新資料的能力)。傳統 AI 的設計是為了執行預先決定的任務,並根據所學的資料辨識和分析影像和聲音,藉以預測結果。生成式 AI 就如其名,是指透過深度學習持續強化學習過程,甚至結合人類尚未提供的資訊和資料,進而「生成」(即創造) 全新的內容。

AI 的不同階段和儲存工作負載需求

在 AI 系統中,透過資料收集、轉換、學習和推論等各階段執行不同的 AI 功能,每個功能都對應至不同的工作負載。這些工作負載佔用系統的核心區域,例如 GPU、CPU、主機記憶體和資料儲存裝置。資料儲存裝置,通常是 SSD 和 HDD,必須滿足不同的工作負載需求。

攝取

將大量原始資料匯入儲存裝置

轉換

以適當的格式準備資料以供分析、清理和驗證

儲存裝置會將格式化的資料儲存並傳輸至 GPU 伺服器。儲存裝置需要高容量和高處理量 (循序讀取)。

訓練/調校

透過 AI 演算法處理、評估結果並改善準確性

儲存裝置會儲存中間結果並快取訓練資料。為了避免在發生故障或運算錯誤時需要從頭開始,會儲存快照。由於必須在這些快照輸出期間停止 GPU 運作,需要高處理量來在短時間內完成此流程。

推論

模型會辨識新模式並推斷出結論

訓練後新增或更新的資料,以及高度機密的資訊,會儲存在單獨的資料庫中。儲存裝置需要高容量和高處理量 (循序讀取)。

鎧俠的 AI 活動

鎧俠多年來一直針對 AI 領域投入研究和開發。

1. 運用 AI 實作的自動化工廠

BiCS FLASH™ 和其他快閃記憶體都是在鎧俠的四日市工廠製造,這座智慧工廠整合了各種尖端製造技術。大數據是從製造和測試系統收集而來,並使用機器學習和其他 AI 技術進行分析,有助於提高生產力。

2. 「以記憶體為中心的 AI」研發 (使用搜尋技術的 AI)

鎧俠針對如何建立和評估結合大型語言模型 (LLM) 與搜尋技術的系統,執行了相關的研究。

AI 產業和資料儲存未來展望:在推論時代發揮最大化的生成式 AI 效能

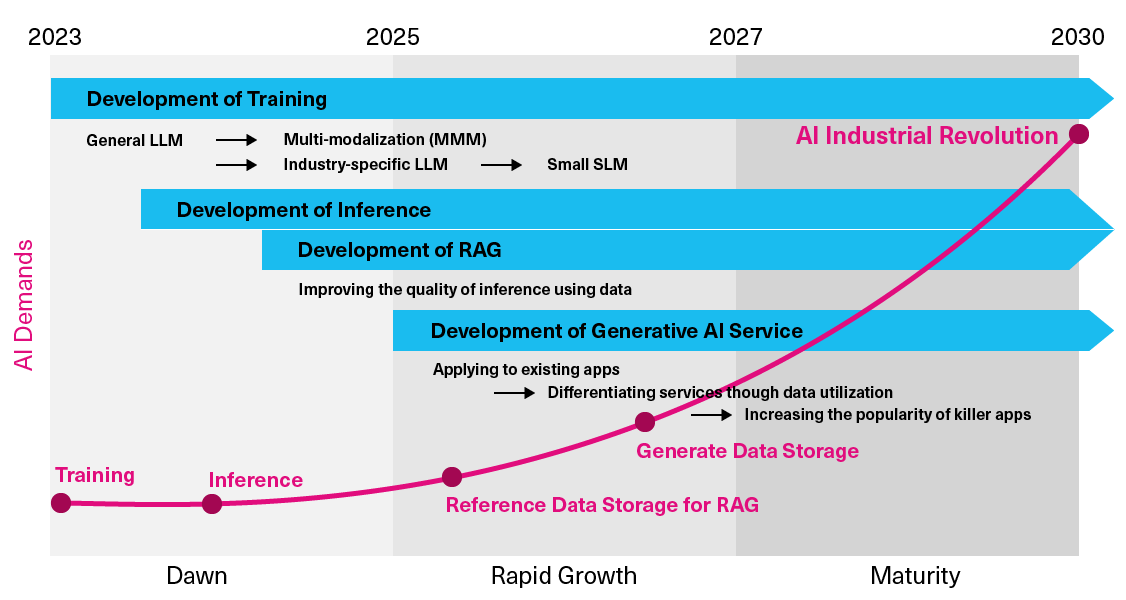

大型語言模型 (LLM) 於 2022 年底問世,吸引了全球關注,帶動科技巨擘 (即開發出改變世界的技術的科技公司) 大舉投入學習和推論領域,催生了生成式 AI 的誕生。LLM 提供的服務預計將整合到各種商業模式、產業和社會中。

為了提高推論的準確性、相關性和及時性,我們推出了一種名為檢索增強生成 (RAG) 的新方法,旨在最大限度提升推論的有效性。

在生成式 AI 系統中使用 SSD (學習/推論)

資料是任何生成式 AI 系統的必要元素。SSD 正逐漸成為儲存資料的重要方式,其特性包括非揮發性、大容量和高速。SSD 隨著生成式 AI 的不同階段持續演進,因此對 SSD 的需求正迅速增加。預計在 2024 年至 2030 年之間,SSD 的市場將大幅成長約 40 至 50 倍。

鎧俠相信到 2030 年,以下四種趨勢會影響中長期的前景展望:

- 學習的發展

- 推論的發展

- RAG 增強推論的發展

- 生成式 AI 服務的發展

SSD 預期將在所有這些趨勢中扮演關鍵角色。

從硬體角度來看 SSD 的優勢

在生成式 AI 系統中,會使用昂貴的 GPU 來進行訓練和推論,如果僅使用揮發性 DRAM,很難處理生成式 AI 流程所需的大量資料。因此,資料處理對於許多任務至關重要,例如:從非揮發性儲存裝置提供訓練資料、在推論期間參考 RAG 資料以及儲存產生的資料。

現代儲存裝置的一項重要需求,就是協助提高 GPU 使用率,讓昂貴的 GPU 得以發揮最大價值,同時讓電源和空間效率最大化。如果需要更大的儲存容量時,就會想到 HDD,但 HDD 受限於機械特性,例如媒體旋轉延遲和讀/寫頭的移動。這會導致讀/寫延遲比 SSD 高出 100 倍以上,進而影響整體電源效率。SSD 支援 AI 儲存服務,最大化高效能 GPU 的處理效率,並滿足未來不斷增加的容量需求。

SSD 用於推論需求的優點

許多公司目前已在使用 LLM 改善營運效率和生產力。

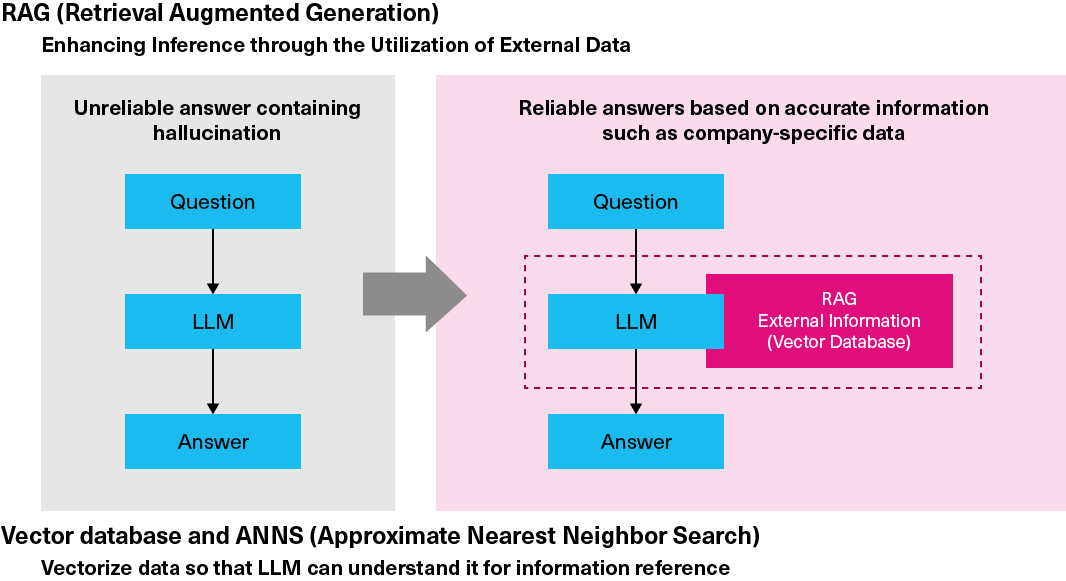

但 LLM 擁有的知識僅限於訓練期間使用的資料集,可能已不合時宜。較舊的 LLM 可能無法針對要求最新、公司專有或機密資訊的問題或指示產生準確的結果。這些不準確的結果有時會偏離問題,稱為 AI 幻覺。

RAG 以向量資料庫的形式,在 LLM 之外納入更準確的知識和資料,藉此解決 AI 幻覺的問題。RAG 使用一種基於向量相似性、具有資料檢索功能的資料庫軟體,稱為向量資料庫。許多公司都對 RAG 感興趣,因為此功能可利用非公開資訊增強 LLM 功能,進而提高 AI 模型的準確性。

在 RAG 中,為找出最接近查詢向量的向量 (以及儲存的知識資料之間的對應資料),需要計算從數百到數千維度的高維度向量之間的相似度。即使是最新的 AI 伺服器,也是一項密集的任務。為解決此挑戰,可使用近似最近鄰 (ANN) 搜尋與索引,將比較向量縮小為少量向量,以尋找近似解決方案。

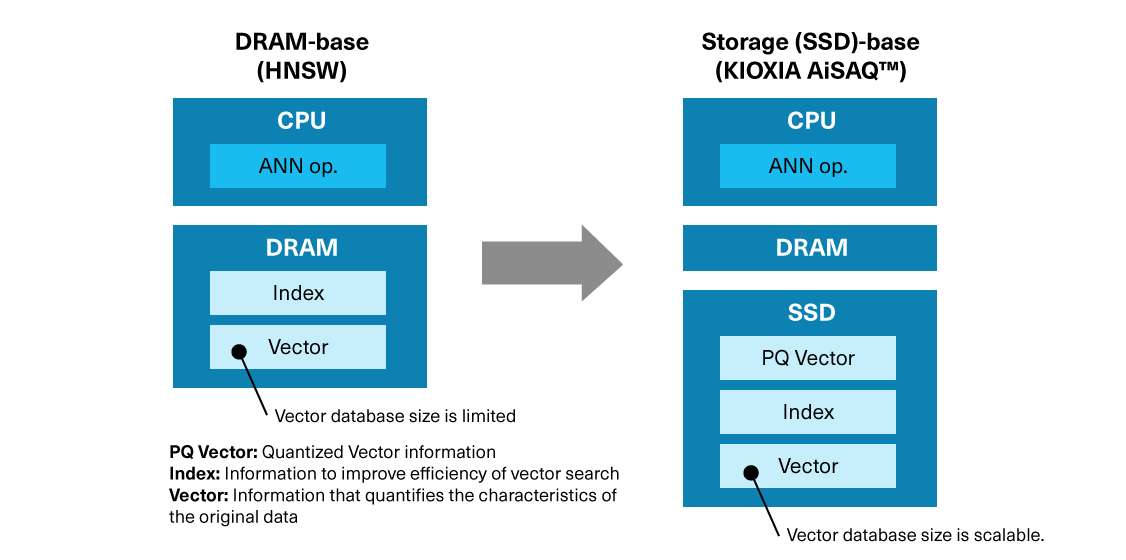

ANN 搜尋有多種方法,包括以 DRAM 為基礎的分層可導覽小型世界 (Hierarchical Navigable Small World,HNSW) 和由 Microsoft 開發的 DiskANN,其主要以儲存裝置為基礎。目前,在 DRAM 中儲存向量和索引的 HNSW 已獲得廣泛使用。在此方法中,向量數量 (代表可利用的知識量) 受到伺服器 DRAM 數量所限制,因此侷限了 RAG 系統基於大量知識日益發揮越大成效的能力。

鎧俠已開發出 KIOXIA AiSAQ™ 軟體,其為使用 SSD 的全新 ANN 儲存方法。為了進一步利用 SSD,特別是在快速成長的 AI 市場,鎧俠將繼續推進這項重要儲存技術的研發。

KIOXIA AiSAQ™ 技術:由鎧俠開發的 AI 創新

顧名思義,KIOXIA AiSAQ™ (All-in-Storage ANNS with Product Quantization) 軟體會將量化資料特性 (PQ 資料) 和所有 ANN 元素的資訊傳輸至 SSD 儲存裝置,以最佳化 RAG 階段中用於向量搜尋流程的 ANN 搜尋演算法。此軟體已透過開放原始碼方式發行,為市場提供更高品質的生成式 AI 應用程式。

在 AI 工作流程中,索引資料通常儲存在 DRAM 中,以提高向量搜尋的效率。KIOXIA AiSAQ™ 技術將索引資料放置在 SSD 上。

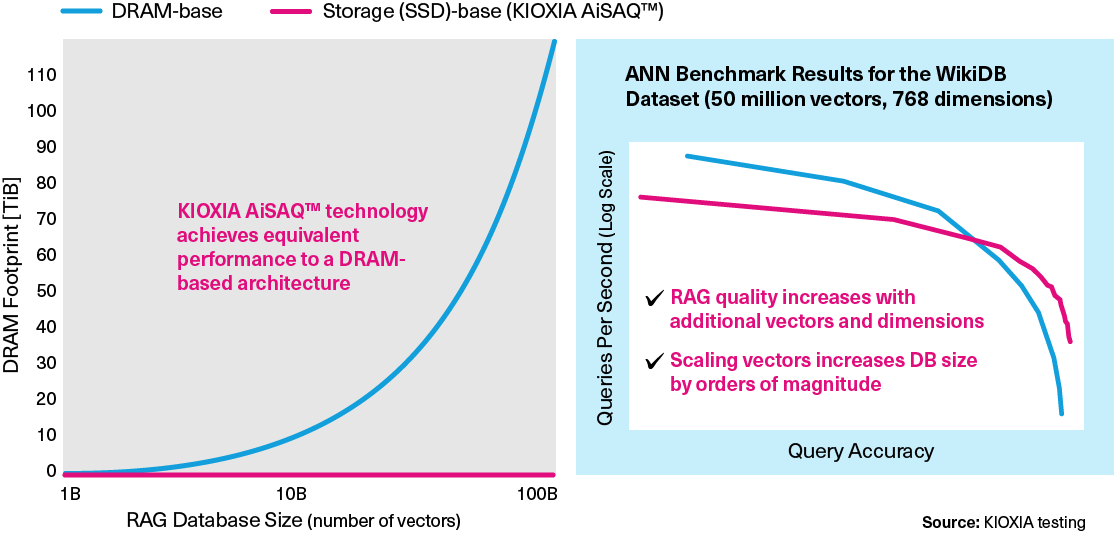

為了獲得更準確的 AI 查詢,RAG 向量資料庫將成長和擴展。針對 DRAM 型的方法,較大的資料庫需要更多 DRAM (下圖左圖)。從效能角度來看,SSD 型搜尋的效能優於 DRAM 型搜尋,包括查詢準確性和每秒查詢數 (下圖右圖)。

這種創新的 RAG 技術具有成長潛力,可在不犧牲效能的情況下改善 ANNS,而且使用價格較低的 SSD 而非昂貴的 DRAM。

KIOXIA AiSAQ™ 軟體下載

KIOXIA AiSAQ™ 軟體為開放原始碼。請點選連結下載。

GitHub:

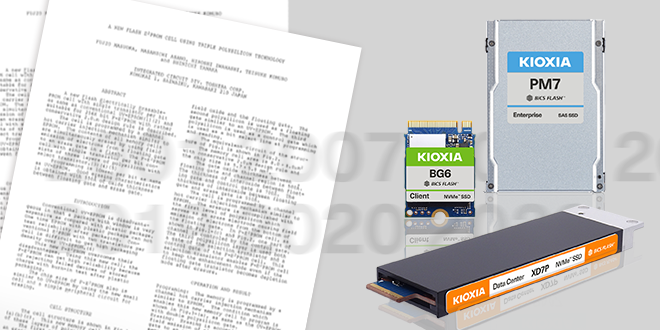

支援 AI 市場的 KIOXIA 產品

介紹適用於 AI 工作負載的 KIOXIA 企業級和資料中心 SSD。

- 容量的定義:依 KIOXIA 定義,1MB 代表 1,000,000 位元組,1GB 代表 1,000,000,000 位元組,1TB 代表 1,000,000,000,000 位元組。但電腦作業系統使用 2 的次方來定義 1GB = 2^30= 1,073,741,824 位元組,因此顯示的儲存容量較低。可用的儲存容量 (包含各種媒體檔案的範例) 取決於檔案大小、格式、設定、軟體、作業系統及/或預先安裝的軟體應用程式,或媒體內容。實際格式化容量可能視情況有所不同。

- NVMe 是 NVM Express, Inc. 在美國和其他國家的註冊或未註冊標誌。

- PCIe 和 PCI Express 是 PCI-SIG 的註冊商標。

- 其他公司名稱、產品名稱和服務名稱可能是第三方公司的商標。